Encounters with Maestro and Wrangler

A few days ago, I came across the short preview of an analytics software from Tableau that is called Maestro. This software – which is being called project by Tableau as it is supposed to become part of the tableau software products – is focussing on preparing data before the analyst is analyzing the data. Preparing data starts with importing data from one or more data sources and combining them via different set operations. Traditionally this is done via textual commands (e.g. written in SQL, MDX), whereas in Maestro it is done via a graphical interface which is visualising data sources, the ways they are combined and the transformations the user is applying to the data. This interface is presented in a pane which is called the „Flow“ and it reminds me of the visualisation of data operations in the Trifacta Wrangler which is focussing completely on the data preparation phase for data analysts.

There are even more parallels between Project Maestro and Trifacta. A large part of work before an analyst starts the analysis itself, he needs to invest into exploring the technical nature of his data and clean them up. Real world data are messy: columns having the wrong data type, data are missing, same things written in different ways, and so on. Everyone working with data knows that much time is invested into this kind of work. Smart analytics software like Maestro and Wrangler are supporting the user in multiple ways. Some examples are assistive technologies like:

- automatically analysing imported data and categorizing, structuring it and displaying the data type

- profiling the data values and showing the distribution of current values in a histogramm, so that the user can discover missing, mismatching or inconsistent values more quickly.

I have discussed some of those features in analytics software in more depth in the article „Von der Tabellenkalkulation zur assistenzgestützten visuellen Analyse“ for the book „Qualität und Data Science in der Marktforschung“. In my article I identify important changes in interface paradigms of Business Intelligence software from an Interaction and UX Designers point of view.

From Tabular Calculation to Assistent-supported Visual Analytics

Written in summer 2017, the article shows and explains that interfaces not only of BI software but of data analytics software in general are changing towards:

- deep and more intelligent usage of visualisation of data in all phases of the analysis

- integration of assistive technologies and libraries using artificial intelligence and machine learning

- Interface design making use of state-of-the-art visual and interaction design principles

Both Trifacta Wrangler and Project Maestro are part of an overall change in the way, user interfaces for analytics software are designed. And these changes are connected with changes in the type of user who is using these kind of tools. Previously the user types Data Analyst and Technical Architect have been the almost exclusive user of Analytic tools and handed over the results to the information consumer.

Nowadays, the information consumer has evolved into the new user type of information prosumer, as I call him along the lines of Tofflers „prosumer“ definition. An information prosumer is a person who is analysing data on his own, navigating through all the available data, exploring the data ad-hoc, and adapting information depth and width of his dashboard to his current and individual needs, without having been trained in expert tools for data retrival, ETL, BI, architecture of data warehouses and the like. Keywords connected with this already emerged type of user are „democratisation of data“ and „citizen data scientist“.

In my above mentioned article I discuss in depth why this user type matters a lot to software engineers, UX designers and product owners and what is making the difference to the information consumer which will still exist but did not have much relevance in professional analytic tools.

One important thing: all of the book is written in German only … sorry!

UPDATE in 2021:

My article is part of this excellent book „Qalität und Data Science in der Marktforschung“ along with other very informative articles. You will get table of content and previews in the Springer Shop and this is also where you can order online, both as e-book and as printed book.

Title: Qualität und Data Science in der Marktforschung

Subtitle: Prozesse, Daten und Modelle der Zukunft

Editors: Bernhard Keller, Hans-Werner Klein, Thomas Wirth

Springer Gabler

Abstract

Datenvisualisierung, Visual Storytelling und Data Exploration sind wichtige Methoden, um gutes interaktives und erlebbares Informationsdesign zu entwickeln. Anhand der Applikation „Wohnungseinbrüche in Deutschland“ wird dargelegt, wie aus statischen Daten erlebbare Informationen mit hoher Interaktivität werden und damit Wissen und Verständnis effizient vermittelt werden kann. Zusätzlich wird erläutert, mit welchen Layoutmaßnahmen sich mehrere Informationsabschnitte zu einer kohärenten Webpage zusammenbinden lassen.

Kontext

Dies ist der zweite Artikel in meiner Folge, in der ich Webapplikationen analysiere, die im Rahmen meiner LV Multimediales Informationsdesign 2014/15 von Studenten am FB Online Medien erarbeitet wurden und die sich durch gutes, interaktives und zeitgemäßes Informationsdesign auszeichnen.

Innerhalb der studentischen Projekte sollten Inhalte aus Printberichten nicht nur in das Medium Web überführt und eine medienadäquate Benutzerführung entwickelt werden. Darüber hinaus sollten die Studenten die Inhalte mittels aktueller Webtechnologien visualisieren und interaktiv erlebbar machen. In der hier präsentierten Arbeit mussten dazu die im Printbericht vorhandenen Daten ausgewählt und eine neue Informationsarchitektur erarbeitet werden musste.

Innerhalb eines gegebenen Zeitraumes von 10 Wochen wurden die interaktive Webapplikation sowohl konzipiert als auch in einem funktionierenden Prototypen umgesetzt. Dieser Prototyp wird in diesem Artikel betrachtet.

Eckdaten zur prototypischen Applikation „Wohnungseinbrüche in Deutschland“

- Die prototypische Applikation ist hier aufrufbar. [Quelle 1]

- Sie ist für die aktuellen (2014/15) Versionen der Browser FF, Chrome, IE, Safari optimiert

- Ihr liegt das Kapitel „Thema aktuell: Wohnungseinbruchdiebstahl“ der als Printbericht publizierten „Polizeiliche Kriminalstatistik 2013“ [Quelle 2] zugrunde.

Adaptives One-Page Design als Layoutgrundlage

Die studentische Gruppe wählte aus der Datenmenge fünf Themen, deren Datenumfang entsprechend auf fünf Abschnitten darzustellen sind. Hinzu kommen die das Thema einleitende Startseite, eine Abspann-Seite und ein Impressum. Die gesamte Website, also die Summe aller einzelnen Abschnitte, ist als One-Pager mit einer konstant vorhandenen Navigationsleiste geschickt gestaltet, so dass der User sie sowohl linear durchscrollen kann als auch mittels der Navigation einzelne Themen direkt ansteuern kann. Nebenbei wird mittels kontrollierter Scroll-Transition erlebbar gemacht, dass der einzelne Abschnitt Teil einer einzigen Seite ist.

Ein Vorteile des entwickelten Screendesigns ist, dass immer nur die Informationen des jeweiligen Themas betrachtet werden. Aus UX-Sicht wird dabei zum einen die kognitive Last für den Nutzer durch das Ausblenden nicht-relevanter Information begrenzt. Zum anderen wird die Website als eine Zusammensetzung verschiedener Seiten wahrgenommen, obwohl sie technisch und interaktionsdesignerisch eine einzige Seite ist. Dazu trägt wesentlich das adaptive Design bei, das den Hintergrund des jeweiligen Abschnitts formatfüllend an die jeweilige Monitorgröße anpasst und den Inhalt vertikal und horizontal zentriert. All diese designerischen Maßnahmen wurden mittels jQuery und fullpage.js umgesetzt.

Von statischer Datendarstellung zum interaktiven Informationsdesign

Führen wir uns vor Augen, was das Ausgangsmaterial der studentischen Gruppe war: ein PDF mit umfangreichen Tabellenwerken, durchsetzt mit einigen Charts und interpretierenden Texten, die Schwerpunkte in den umfangreichen Daten setzen und zusammenfassend interpretieren. Der vorwiegende Charakter aus Sicht des Kommunikationsdesigns ist der einer strukturierten Datensammlung. Alles durchaus lesbar für das Printmedium gesetzt; aber nicht geeignet, um den Leser zu motivieren, sich mit dem Kommuniziertem intensiver zu befassen. Der Bericht wirkt eher wie: „Wir haben eine Pflicht, die Öffentlichkeit über die Häufigkeit von Verbrechen zu informieren – hier sind unsere Ergebnisse.“ Und vermutlich – und völlig berechtigt – ist genau dies die Motivation des Printberichts gewesen.

Ganz anders war die Motivation der Studenten angesichts der Aufgabenstellung im Rahmen der Lehrveranstaltung. Es ging ihnen um die Visualisierung von kriminalistischen Key Indicators des Wohnungseinbruchs wie Tatzeit, Tathäufigkeit, Wohnsitz in Relation zum Tatort und anderen vorhandenen Daten, die Muster aufweisen können und die Anlass zur Hypothesenbildung geben. Sie blieben dabei aber nicht stehen, sondern gingen darüber hinaus. Es ging ihnen auch darum, die Daten zum Erzählen zu bringen, sie erinnerbar zu machen, das Erschreckende an der Häufigkeit dieses Verbrechens und der geringen Aufklärungsquote erlebbar zu machen, das Thema in einen Bezug zum Nutzer zu stellen. Aus dieser Motivation heraus entstanden solche Ideen wie der Einbruchszähler, die Textboxen mit starker Betonung der numerischen Werte oder der hoch-interaktive Vergleich von Täterprofilen.

In der designerischen Bearbeitung der einfachen Datendarstellung hin zur informierenden Erzählung erkenne ich vier Methoden – man könnte sie auch Prinzipien nennen – der Transformation der Datenpräsentation: Visualierung von Daten, Visual Storytelling, Data Exploration und Translation into the world of the user. Im folgenden werde ich diese Methoden anhand konkrete Abschnitte und Aspekte der Applikation „Wohnungseinbrüche in Deutschland“ beispielhaft darlegen.

Visualisierung von Daten

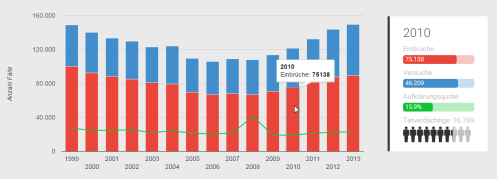

In der ursprünglichen Printdarstellung werden – nicht nur, aber vorwiegend – die Daten in Tabellenform dargestellt. Das Beispiel der Gesamtzahl der Wohnungseinbrüche in Deutschland in den Jahren 1999 – 2013 in Abb. 2:

Diese tabellarische Darstellungsform hat bekannten Nachteile für die Verarbeitung der dargestellten Daten:- Alle Kategorien und Daten sind in der Bedeutung gleich gewichtet

- Dadurch wird Wesentliches von Unwesentlichem nicht unterschieden

- Bezüge zwischen den Werten, Muster der Werte, Minima, Maxima muss der Nutzer durch dediziertes Lesen und Vergleichen sich erarbeiten und das Erarbeitete sich merken

- Abweichungen vom Durchschnittswerten, mögliche Korrelationen und Verteilungsmuster sind nur grob abschätzbar

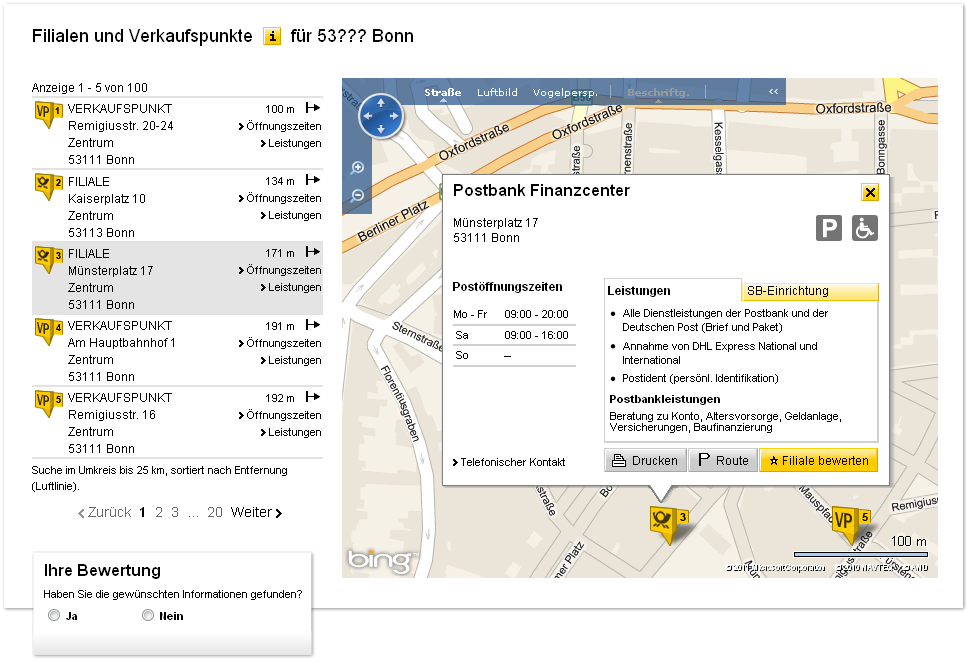

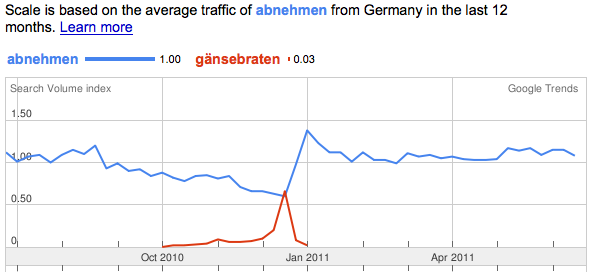

Im Vergleich zur Tabelle das kombinierte Zeitreihendiagramm in Abb. 3, bestehend aus gestapelten Säulen mit einer Prozentlinie, dazu eine Textbox. Hier der Link zum entsprechenden Abschnitt der Applikation.

Abb. 3: Wohnungseinbrüche in Deutschland 1999 – 2013. Chart mit dynamischer Legende, Screenshot aus der Webapplikation

Ziele und Maßnahmen der Umgestaltung der Datenpräsentation waren:

- Nicht nur Daten darstellen, sondern aus den vorhandenen Daten Informationen schaffen

- Informationen so hierarchisieren und verknüpfen, dass Wissen daraus werden kann.

- Für den Erkenntnisvorgang Wesentliches herausstellen und leicht erfassbar zu präsentieren durch graphische Umsetzung numerischer Werte, d.h. durch Präsentation von Graphen, im englischen Sprachgebrauch üblicherweise „Charts“, im deutschen „Diagramme“ genannt.

- Wesentlich ist in diesem Abschnitt das Erkennen von Mustern in der Zeitreihe, also die Relationen der drei Variablen Einbrüche, versuchte Einbrüche, Aufklärungsquote zueinander innerhalb eines Jahres und ihre Entwicklung über mehrere Jahre.

- Die numerische Werte werden beim Hovern eines Datenpunktes in der rechten Textbox in einer hierarchisierten Textform dargestellt.

Die Datenvisualisierung ist ebenfalls Schwerpunkt meines zweiten Beispiels, dem Abschnitt, der die statistische Beziehung zwischen geographischer Lage der betroffenen Wohnung und dem Wohnsitz des Täters darlegt. Im Printbericht wirkt diese Information überschaubar:

Abb. 4: Wohnsitze der Einbrecher in Beziehung zum Tatort (2013) – Tabelle. Screenshot aus dem Printbericht. Quelle [2]

Der entsprechende Abschnitt in der Applikation besteht aus einer Kombination von Diagramm mit einer dynamischen Textbox.

Abb. 5: Wohnsitze der Einbrecher in Beziehung zum Tatort (2013). Screenshot des interaktiven Diagramms.

Die graphische Visualisierung mittels konzentrischer Kreise ist in der Kernidee klar und intuitiv erfassbar; ihr mangelt es jedoch an letzter Konsequenz, da weder Radien noch Flächen der verschiedenen Merkmalskreise die gegebenen Daten widerspiegeln. Eine gute Idee, die ausbaufähig ist.

Visual Storytelling

Ich habe einige Male erlebt, dass Visual Storytelling anfänglich so verstanden wird, als ob es darum ginge, passend zu den sachlichen Informationen eine Geschichte mit Akteuren, Orten und Handlungen sich auszudenken, in die dann die sachlichen Informationen eingebettet werden. Das ist nicht damit gemeint. Wenn ich dieses Verständnis anhand erster Ideenskizzen der Studenten erkenne, weise ich darauf hin, dass es nicht um eine Anreicherung mit weiteren Elementen geht, sondern um eine Reduzierung im Sinne einer Verdeutlichung. Visual Storytelling meint die graphische Inszenierung der Bedeutung von Informationen. Damit ist sie immer eine Interpretation und deshalb braucht es einen vorsichten und bewussten Einsatz dieses Prinzips.

Die Akteure des Visual Storytellings sind nicht erfundene Akteure, sondern die Daten. Um die Metapher der Inszenierung weiter zu führen: als Designer muss ich die Daten sprechen und agieren lassen. Das Layout ist ihr Bühnenbild, die Bühnenszenen sind die räumliche, interaktive oder/oder zeitliche Gliederung der Geschichte. Ihre Kostüme sind die graphische Ausprägungen, in dem die Daten auftreten: als beschriftete Zahlen, als Illustrationen der numerisch erfassten Kategorien, als Balkendiagramm oder auch als Tabelle …. Viele Kostüme sind möglich, aber es sind diejenigen zu wählen, die das Verständnis für den dargestellten Sachverhalt, für die Story, beim User am ehesten bewirken.

Die vorliegende Webapplikation weist keine breite Anwendung des Visual Storytelling auf. Lediglich im Abschnitt „Fakten“ werden stichwortartig Informationen mit Visuals verknüpft um schnell und pointiert zu kommunizieren: beispielsweise die überwiegende Anzahl an Einmaltätern oder den durch Einbrüche verursachten Schaden in Höhe von 427 Mrd. EUR allein im Jahr 2013.

Data Exploration

In der Applikation bündelten die Studenten mehrere umfangreiche Tabellen des Printberichts in einem Tool, das dem Nutzer die Möglichkeit gibt, innerhalb der Datenmenge selber zu explorieren: nach bestimmten Kategorien zu sortieren, Teilmengen der Daten nach bestimmten Filterkriterien zu sichten usw. Im Abschnitt „Die Täter“ kann der Nutzer zwei unterschiedliche Tatprofile konfigurieren und miteinander vergleichen, indem er nach verschiedenen Attributen (männlich oder weiblich, verschiedene Altersklassen, Einbruchszeit Tag oder Nacht, Deutscher oder Nicht-Deutscher) filtert.

Die im Screenshot gewählte Konfiguration vergleicht die Anzahl von Einbrüchen tags mit nachts, begangen von Einbrechern beiderlei Geschlechts in der Altersgruppe zwischen 18 – 50 Jahre.

<Hinweis> Der Unterschied zwischen Tag und Nacht scheint nicht sehr groß zu sein. Der Blick in die 2015 publizierte Studie des GKV [Quelle 3] deutet aber darauf hin, dass eine präzisiere Datenerhebung sehr wohl präferierte Einbruchszeiten gibt – und zwar sowohl was die Monate betrifft wie auch die Uhrzeiten. Dies zeigt zum einen, dass zum Zwecke des Erkenntnisgewinns und für Schlußfolgerungen die Nutzung mehrere Datenquellen erforderlich ist und dass die Granularität der Daten maßgeblich auch die Möglichkeit seriöser Hypothesenbildung beeinflusst. </Hinweis>

Übersetzung in die Alltagswelt des Nutzers

Diese Methode zielt darauf ab, einen Bezug zur Welt und Umgebung des Nutzers schaffen. Ein überaus gelungenes Beispiel stellt die Webseite US Federal Budget Visualized dar, die das Billionen Dollar umfassende Budget der USA als Stapel von Geldmengen bildhaft darstellt und sie in Relation zu bekannten Dingen wie Sofas, Autos, Häusern und Wolkenkratzern setzt. Beeindruckend!

Im vorliegenden Fall blieben die Studenten näher am Boden: Es ging Ihnen darum, dass der Printbericht die Gesamtzahl von 149.500 Einbrüchen in Deutschland schlicht konstatiert. Wie lässt sich diese große Zahl dem einzelnen Nutzer nahebringen, fragten sich die Studenten. Die Antwort kam mittels einer kurzen Rechnung, nach der durchschnittlich jede dreieinhalb Minuten ein Einbruch begangen wurde. Von dort aus war es nicht weit zur Idee des „Einbruchs-Counters“, der die durchschnittliche Zahl der Einbrüche in der Zeit zählt, während sich der User mit der Applikation beschäftigt. Aus abstrakten großen Zahlen werden konkrete Bezüge in die Alltagswelt des Nutzers nicht nur benannt, sondern erlebbar gemacht.

Die textuelle Informationsform im Printbericht:

Abb. 8: Zentraler KPI-Wert „Gesamtzahl der Wohnungseinbrüche“ in der nüchternen Textform des Printberichtes.

Im interaktiven Informationsdesign wurde daraus folgende Form:

Insgesamt nutzt die Webapplikation „Wohnungseinbrüche in Deutschland“ alle der vier o.g. Methoden, um interaktives und den User involvierendes Informationsdesign zu erzielen. Diese Methoden wurden in unterschiedlicher Qualität und Intensität verwendet: Visualisierung der Daten häufig und deutlich, Visual Storytelling in geringem Maße.

Wohnungseinbrüche in Deutschland: Zahlen und ihre Hintergründe

Die Beschäftigung mit den Zahlen hat über die designerischer Aufgabenstellung hinaus auch tiefere Neugier, Fragestellungen und durchaus auch Betroffenheit zum Thema ausgelöst – sowohl beim Dozenten wie auch bei der studentischen Arbeitsgruppe. So stellte sich beispielsweise für die Beteiligten die Frage, wie es denn zu erklären sei, dass NRW dasjenige Bundesland ist, das 2013 mit 313 Einbrüchen pro 100.00 Einwohnern nach Bremen, Hamburg und Berlin die höchste Einbruchsquote aufweist. Wir hatten dabei Medienberichte im Hinterkopf, in denen über ausländische Einbrechergruppen vorwiegend aus dem osteuropäischen Raum berichtet wurde. Nach unserer Vorstellung wäre die logische Konsequenz, dass Bundesländer wie Bayern, Thüringen oder Sachsen als östlich gelegene Bundesländer die höchsten Einbruchsraten aufweisen. Und nach der Datenlage waren sie es nun mal nicht. Wie geht das zusammen?

Nun, zuerst einmal können wir unsere empirische Basis verbreitern, da seit der Lehrveranstaltung die entsprechenden Zahlen aus dem Jahre 2014 veröffentlich wurden. Daraus hat die GKV eine Graphik erstellt, die zwar illustrativ etwas überzogen, aber dennoch sachlich richtig die geographische Verteilung der Quoten für Wohnungseinbrüche darstellt:

Wir ersehen daraus, dass auch 2014 NRW nach den beiden Stadtstaaten und Berlin immer noch die mit Abstand höchsten Einbruchsquoten aufweist. Insbesondere das Ruhrgebiet mit seiner dichten städtischen Bebauung bildet geradezu einen Hotspot der Einbrüche.

Ich habe in einer umfangreichen Reportage über Opfer und Täter in Krefeld Zusammenhänge gefunden, die erklären, weshalb gerade Städte im Ruhrgebiet diesen Hotspot bilden:

„So wie Victor H. in vielem typisch für die Diebe aus Osteuropa ist, so sind die W.s typisch für deren Opfer. Von Krefeld aus kann das strebsame Kleinbürgertum zügig die Betriebe des Ballungsraums an Rhein und Ruhr ansteuern, mit der Bahn oder mit dem Auto über die B 57 und die A 44. Doch während das Kleinbürgertum in Büros, Geschäften und Fabriken am Erhalt seines Besitzes und an seinem Aufstieg arbeitet und die Kinder in der Schule sind, pendeln die Diebe über dieselben Verkehrsadern in die tags verwaisten Wohnquartiere ein. Das dichte Netz aus Autobahnen und Schnellstraßen an Rhein und Ruhr ist perfekt für die Flucht. Darum kommen die Einbrecher nach Marl und Gelsenkirchen, nach Monheim und Bad Godesberg, nach Leverkusen, Recklinghausen, Mülheim an der Ruhr. Eine Klauhochburg liegt hier neben der anderen.

54.000 der knapp 150.000 Einbrüche des Jahres 2013 in Deutschland geschahen allein in Nordrhein-Westfalen. Insgesamt gab es in ganz Deutschland fast 50.000 mehr solcher Delikte als noch 2006 – ein Anstieg um ein Drittel. Statistisch gesehen erwischt es nun alle dreieinhalb Minuten jemanden. Nur wen, ist unberechenbar. Die Diebe aus Osteuropa, sagt der Polizist Uwe Laußmann, spähten ihre Opfer nicht groß aus. „Die fahren von der Autobahn runter, biegen zwei-, dreimal ab und legen los.“ [Quelle 4]

Noch einige Literaturhinweise zum fachlichen Thema Wohnungseinbrüche:

Ich empfehle die Reportage „Auf Raubzug in Krefeld“ allen Interessierten. Hier geht nur nebenbei um quantitative Dimensionen dieses Delikts. Im Fokus dieser Reportage stehen vor allem Einsichten in Umstände, Motivationen und gesellschaftliche Randbedingungen am Beispiel konkreter Menschen.

Die neuen Zahlen zu den Wohnungseinbrüchen für 2014 gibt es in der Polizeilichen Kriminalstatistik 2014. Der Artikel „Gelegenheit und Drogensucht machen Diebe“ in der FAZ vom April 2015 interpretiert die damals neu veröffentlichten Statistiken von 2014.

Eine kürzlich erschienene Studie GDV Einbruch-Report 2015 des Kriminologischen Instituts Niedersachsens [Quelle 3] beschäftigt sich ebenfalls mit Wohnungseinbrüchen; dabei aber schwerpunktmäßig aus der Perspektive der Opfer. Interessant finde ich vor allem der der Studie zugrunde liegende Perspektivwechsel, der nach den emotionalen Folgen für die Betroffenen und geändertem Verhalten und emotionalem Bezug zur Wohnung fragt.

Quellen

[1] Flaig, Henriks, Müller, Rascher: Wohnungseinbrüche in Deutschland. Arbeit im Rahmen der Lehrveranstaltung Multimediales Informationsdesign 2014/15, Fachbereich Online Medien an der DHBW Mosbach.

[2] Bundesministerium des Innern: Polizeiliche Kriminalstatistik 2013, Kap. 9 Thema aktuell: Wohnungseinbruchdiebstahl , S. 53 – 59.

[3] GKV: Mehr Schutz für den privaten Lebensraum. Einbruch-Report 2015 der Deutschen Versicherungswirtschaft, Berlin 2015

[4] Kowitz, Dorit: Auf Raubzug in Krefeld, in Die Zeit 9/2015

Abstract

Layouting GUIs for multi-lingual software requires often prediction of the screen space that is needed for terms in different languages and alphabets. In this article we examine a given set of 385 key terms used in balance sheet accounting multiplied by 11 languages with methods of descriptive statistics. We will find and discuss patterns and relations that allow to determine the required screen space if the length of the English term is given. Methods and rules of thumb are derived that can be applied by practitioners who are developing and designing user interfaces for multiple languages.

Why in English?

When some of my Czech colleagues recently were showing interest in reading some of my articles, I became aware that writing this blog in English rather than in German language would make the presented thoughts more accessible not only to my colleagues in Prague but also to other non-German speaking persons. That’s why I will try to write my articles in English language in general and see how this works out. However, articles which deal with websites and applications layouted, written and labelled in German language (like the ones my students are developing) will continue to be in German.

Screen space for translated terms

Some months ago I came across a database file which stores the terms used in balance sheet accounting translated into several languages. When working on screen design in multilingual software and content I had wondered if there is a way of estimating the space that is required by the different translations of a given word / term / sentences. Particularly if one is in the situation that the translations are not done yet which is quite common in the production process. The unwanted risk of reserving too little space for the translated terms is: cutting off the term or flowing over to other areas. On the other hand the risk of overestimating the space required by translated terms: wasting screen space and creating unwanted gaps in the layout. Both risks should be avoided. Sure, but how can we tell? Let me put the question in this way: Are there any rules or even algorithms that tell how long a foreign language term might become when it’s translated from English into another language?

When I looked at the translation data I thought I might be playing with them and see what I can find out when I apply some statistical methods to these data. I might even be able to provide some rules of thumb. We should keep in our minds that these rules are restricted to the domain of balance sheet accounting across several languages and cannot be generalized to languages in general. However, we will gain insights from which we can derive rules and approaches for practitioners in screen design and texting. Let us have a look first at the key data of the relevant data base.

Key data of data base

Industry: Financial, Domain: balance sheet accounting

Number of terms (in each language, except Czech): 386

11 Languages:

- English (EN)

- German (DE)

- Spanish (SP)

- French (FR)

- Italian (IT)

- Japanese (JP)

- Dutch (NL)

- Portuguese (PT)

- Russian (RU)

- Chinese (ZH)

- Czech (CZ)

We can consider the typographic parameters being normalized as all terms are formatted in Arial font with text size of 9 pt (in Excel).

Two examples, first hypotheses

Let’s look at one single example, the translations of the long term „Acquisition cost plant and factory equipment“.

Looking at the space occupied by the strings in the different languages we immediately can make a few observations in this particular example:

- The financial term does not consist of a single word but of a combination of several words.

- This applies also for the non-Latin language of Russian with Cyrillic. For Chinese and Japanese I just couldn’t tell by looking at the data.

- The smallest length has about 1/3rd size of the longest one.

- Chinese and Japanese need relative little space.

- Russian needs the most space.

- Some translations seem to incorporate abbreviations (German: „AHK“), others information added in brackets, making terms consisting of different words even more complex

Now let’s examine another example picked out of the database, the short term „Inventories“:

Some of the previous observations are confirmed, others are contradicted or need to be differentiated:

- In the second dataset the Czech translation needs most of the space, not the Russian translation.

- Chinese has still got the shortest length with two characters, but Japanese is quite wide.

One main observation of the term „inventories“ is that every translated term (including the english term itself) is much shorter than in the previous example. So we might suppose that there is some correlation between the length of an English term and its counterpart in other languages. The underlying reason for this one can call evident or even trivial: Simple things need only a short description in any language. To put it the other way round: if we have to describe something complex, we will need several words than describing something simple, in English language as well as in any other. And this relation of shared growth of term lengths might be stronger than the differences between our eleven languages – not necessarily in any case but as a general tendency. This is something to be examined later on as correlation between termlenghts of different languages.

Skimming through all the translations of 386 terms seems to confirm most of the observations made above. In order to get a better overview over the data let us focus first on counting the number of characters (= letters and spaces a term consists of). But before doing this we should state that number of characters of a term does not necessarily equals required space. Languages with Latin alphabet may differ in length depending on the frequency of letters in that particular language: „m“s require more space than „i“s. More important, there seems to be a visually large difference between Latin alphabet and non-Latin ones: We just need to look at our two examples shown previously to notice that Russian, Japanese and Chinese characters seem to require more pixel-width than the average Latin character. However, we start with counting the number of characters of each translated term (see this spreadsheet file „Term Lengths and Means per Language“ in googledocs) keeping in mind that this is not yet the metric we want to have in the very end.

Central Tendency of Term Lengths in different Languages

Let’s start having a look at the arithmetic mean of all the lengths across one particular language and compare those means in absolute numbers.

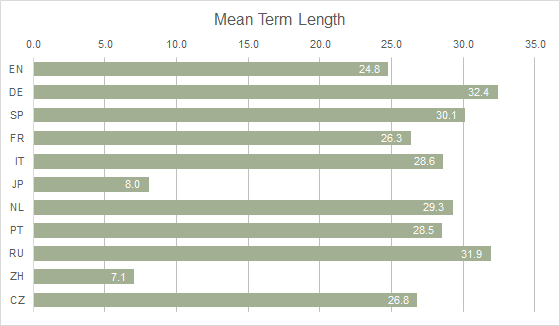

What we can read about the means from Graph 1:

- European languages range from 24.8 (English) to 32.4 (German) characters for the average term in this dataset of balance accounting terms.

- German language has the highest mean of all 11 languages which seems to confirm the general opinion that German texts „run“ rather long.

- Asian languages have dramatically low numbers: The average term counts 7.1 (Chinese) and 8.0 (Japanese). This is in line with our observations of the examples above as documented in Screenshots 1 + 2.

- Russian language is running with Cyrillic alphabet with 31.9 characters for the average term quite long as well, almost as long as German.

We can look at the same values from the English language point of view and compute ratios. To do so the average number of characters being 24.8 in absolute numbers is set to factor 1.0; the other values tell us which ratio the average term length has in the related languages. For instance, we compute that the average term length in German has a ratio value of 1.31 which says it does exceed the average English term length by nearly 1/3. On the other hand, the average Japanese term length is 0.32 and that tells us that in Japanese terms require only 1/3rd of the number of characters than in English. After all, this is giving us already quantitative information.

Taking a look at German

Let us take a closer look at the relation between English and German. From the above figures we derived already that we will need 1/3 more characters for a German term when we translate it from an English term of average length. Some examples from the primary data set are confirming this rough guess:

- EN: „Other short-term payables“ (25 char’s) > DE: „‚Sonstige Zahlungsverpflichtungen“ (32 char’s)

- EN: „‚Bank loans and overdrafts“ (25) > DE: „‚Bankdarlehen und Überziehungskredite“ (36 char’s)

If we filter all English terms with 25 characters (which is the mean for English) we notice that a few of the German translations are having less than 25, but the majority has clearly more than 30 or even 40 characters as Table 3 is showing.

This example let a derive a very rough rule of thumb:

Terms dealing with balance sheet accounting translated from English to German require often 1/3rd or more of term length.

Of course, this is not a scientific deduction; for instance we did not yet look at all the other English terms with more or less than 25 characters. Nonetheless, in some daily layout task applying such a rule of thumb might be better than just knowing nothing about the screen space that needs to be reserved. Before we move on to a broader view looking at the data, let’s switch the perspective to German language for the sake of German designers. We already found out that in our dataset the German terms have the highest number of characters in average. If we normalize Graph 1 to the mean of German terms we get a clear picture of the relations in Graph 3 and this differs a lot from the English perspective we saw before.

Compared with German, the average term of no other language is longer. The closest is Russian with a character length being 98% of German terms, which could exceed required space as the Cyrillic alphabet seems to have more character width – we will examine this aspect later on.

The conclusion comes to our mind that we do not need to care much about reserving additional space for other languages once we do the layout with German terms. Any of the other languages needs fewer characters. So this might be another insight from our data analysis. The Asian languages are placed at such low ratios against German, that it seems to be very unlikely that Japanese and Chinese terms exceed their German counterparts. And in fact: filtering the German terms with extreme few characters in the data set shows that the Chinese terms do not undercut their length, so it looks reasonable to assume that in almost every case the Asian term runs shorter than the corresponding German term.

From a designers perspective, there might a design danger be lurking from an unexpected side that we would need to keep an eye during layouting: such low ratios might result in a layout that could look unbalanced in Asian version because only a few letters occupy a space which had been designed for something four times larger.

Distribution of term lengths in different languages

Until now, we have been looking at the term lengths by the their central tendency in the different languages. We compared some of the means but became aware we need to look at all of the term lengths and their frequency within a particular language. Let’s now examine the distribution of all term lengths within one language and let us then compare the results across languages.

We are graphing histograms [Harris 1] along each language. In each graph we are transforming the discrete variable of term length (values can only be integers) into an interval variable that aggregates term lengths into bins starting from 1 up to 64 characters by steps of 4. This is what the frequency distributions look like for English and German if visualized as histograms:

The comparison of histogram of German with English terms shows:

- Both distributions have a positive skew: the maxima are more to the lower end of the x-axis and we have a tail to the right.

- English terms have no more than 52 characters

- English terms have a clear frequency maximum around x(EN) = 20

- Germany has no clear maximum but rather a plateau ranging from x(DE) = 20 to x(DE) = 32

- German seem to decrease in frequency f(G) after passing its high plateau but increase again towards the end of x(DE) = 64. Among all 11 histograms, German is the only language showing this characteristics and this needs a closer look at the primary data.

What we can see immediately from looking at the primary table being filtered with x(DE)=62,63,64 that some of the longest German terms are already abbreviated. Due to technical reasons the regular translation was already shortened by the translators to avoid exceeding 64 characters. Without this technical constraint the abbreviated terms would have had even more letters. In the histogram this would result in an even longer right tail and each bin showing fewer counts. So we can explain the unusual pattern in the DE histogram with two combined factors: First, German language is consuming per se a lot of letters for the given terms. Second, with a jam because of the technical limit not allowing more than 64 characters.

Taking a look at the primary data with filtering only the German terms with 63 to 64 characters (Table 4) tells us that in this results truncations are quite heavily applied; like in the example „Kum. Abschr. auf and., sachgerecht bez. Gruppen von Anl.-Gegenst“. In addition, we can observe that other translations followed the German abbreviations (e.g. English abbreviation „acc“ („accumulated“) for German „kum“ („kumuliert“) or left away certain parts of the German term (e.g. English „Materials“ for German „Materialaufwand (Roh-, Hilfs-, und Bestriebsst., Waren/Leistungen)“.

Let’s now extend the scope of our examination towards the frequency distribution of term lengths across all 11 languages. I have grouped the languages in the resulting multiple histogram by their well-known relation to the language families Germanic, Romanic, Slavic and Asian.

Looking at the histograms we get some insights into the characteristics:

- Strong confirmation that Chinese and Japanese terms are way shorter than their counterparts in the Germanic, Slavic or Romanic family.

- The Romanic languages SP, FR, IT, PT are similar to each other which was expectable from the well-known similarity of Romanic languages in words and grammers.

- But they don’t look that much different to the Germanic Dutch or Slavic Czech, which was a bit surprising me.

- Just Slavic Russian seems a have a different pattern as very long terms seem to happen quite often. This fits to our previous calculation that Russian is having the second highest mean. But then again: the visual pattern of the Russian histogram does not completely different to, let’s say, Spanish.

- And the pattern of Slavic Czech looks more similar to any of the Romanic languages than to Russian.

After all, the comparison of histograms does not give us very much precise rules when we think about the original aim of reserving space for translated terms. They give us rather a general impression about term lengths. But it is not yet clear if short English terms result in short German / Russian / French / … terms as well and what range of term length we can expect. If we want to examine this question we need to change our approach from analysing one variable to looking at the relation between two variables.

Contingency Tables and Scatterplots

In the next step we will look at the English terms as being one variable and any other language being a second variable. On the basis of our term length data we identify which English term lengths (x) result in which length (y) of another language and aggregate the frequencies in a contingency table. A contingency table gives the frequency f(x,y) of different combinations of values of two (or more) variables.

Scatter graphs (also „scatter plots“) are visualisations of two variables [Harris, 2]. They are useful to convey information about association between the two variables. In order to transfer the contingency table into a scatterplot, we transfer the table into cartesian coordinates. The x-axis represents the length of English terms, the Y-Axis that of the translated language which we want to call Y-Language. Each occurence of a English term with the length x(EN) being translated into the language Y with the length y(Y) results in a point in the cartesian plane. (x,y)-tupels which have no occurrence, i.e. f(x,y) = 0, are left empty. Tupels which occur more than once would be overplotted using this method. In statistics for this case the method of jittering is applied which adds some noise to the values resulting in placing the points near to each other instead of on top. I personally don’t like this visualisation workaround for its unprecision.

From the perspective of data analysis, the question is how we can graph a third dimension. For this case Exel is offering a 3D-Scatterplot-Chart. However, in our case with a range of 64 x-values and 64 y-values the result became quite unreadable. As our 3rd dimension frequency ranges only from 0 ≤ f(x,y) ≤ 14 and only very few are beyond the values of 4, an alternative solution could be to encode the frequency by different shades of the same color via conditional formatting of the cell. The resulting scatterplot is depicted in this tabular scatterplot realized in this google spreadsheet „Scattergraphs of Term Lengths across two languages“

Another approach is to apply transparency to the dots which also results in having a darker color where dots are plotted on top of each other. This is the method I have used to produce the scattergraphs depicted in this article.

Term Lengths English – German

Let us first analyse the relation between English and German term lengths in Graph 6. Every dot in the graph is showing one or more occurences with an English term of a length x and its German counterpart term with the length y. The darker the dot-color, the more frequent this tupel (EN,DE) occured. The resulting scatterplot is enhanced by a light grey diagonal which is showing where an English term and its German translation have exactly the same amount of characters. Not unexpectedly this does not happen very often. Nonetheless, this diagonal seems to be some kind of attractor as the dots are scattered along this diagonal. This pattern is showing us the force of positive correlation between these two languages, expressing the tendency of German translations to get longer in the same degree as the English do.

However, from being more dots being above the diagonal than being below we can read that it is more likely that the German term is longer than the corresponding English. And we can notice at the upper end of the GE axis that a lot of terms have the maximum length of 64 characters and this happens even more frequent when the English terms are between 40 and 50 characters. The blue line is the regression line based on a linear model; within this context we should regard it as summarizing the correlation between our two variables.

This same scatterplot supplies a complete second point of view, which is that we can also look from German perspective. We must only follow the values on the y-axis to the right to find out what is happening to German term lengths when they are translated to English. By this we can see that no dot is placed beyond x=51, meaning that no English term is longer than that – whatever the length of the German one. Of course, we could have concluded that from the histograms, but now we see it! And we see by looking at how many dots are placed left or right to the diagonal, that in general the English translations are shorter than the German terms. If they are longer, they are not exceedingly longer as those dots being right to the diagonal are close to it.

I consider this to be quite informative when being faced with the problem of reserving space for translations that we started off with. And I wonder if the conclusions could be applicable to language characteristics in general beyond the small and domain-specific set we use here. Anyway, let us continue looking closer at the relationships between the English and some other languages.

Term Lengths English – French

Right from the very first glance this Plot looks very different to the EN – DE graph. We see that all dots are quite close to the diagonal. This tells us that French terms do not differ much from their English counterparts.

A few exceptions can be observed near x = 48. However, the correlation appears visually to be very strong, which is confirmed by an calculated correlation coefficient r = 0.89. Also the vertical and horizontal distance of the tupels look quite symmetrical which can be interpreted that in general the term length does not change dramatically when terms are translated.

Term lengths English – Japanese

The scatterplot of English and Japanese terms shows a different pattern with some similarities to the previous one. As in the French graph, the dots are scattered around the regression line. The regression line is in this case not running parallel to the diagonal.

Except one occurrence all Japanese terms have less than 20 characters. The bulk of terms is concentrated with 8 or fewer characters as we can derive from the darker dots being placed at 4 < x < 24. No dot is above the diagonal, so that we can conclude: whatever the English term, no Japanese translation will have more characters. However we need to remind ourselves that the required space might be more as Asian characters appear to be wider than the average Latin character.

As the bulk of the data points are scattered along a line we can assume a positive correlation: the longer the English term the longer the Japanese term. This is confirmed by r = 0.73. However, from the plot we get the impression that this progresses in a much slower rate than in the non-Asian languages. This can be stated more precisely by the gradient b of the regression line being computed as b = 0.27.

From Characters to Pixels

Until now, we have been comparing the number of characters in our 11 languages and found some typical and atypical characteristics by applying methods of visual analytics. In order to move on to the initial aim of estimating necessary screen space, we still have to convert the term-length into pixel width used by the characters of the different languages.

For simplicities sake, we assume that all languages based on Latin alphabet (Germanic, Romanic plus Czech) use short letters like „i“ or „t“ and wide letters like „m“ in a similar proportion – as a look on the primary data might be enough right now to justify this assumption. Cyrillic and both Japanese and Chinese seem to have letters that on average need more space. We want to quantify this by measuring the pixel width of the average character ( i.e. letter and space) in each of the alphabets.

We are using a half-manually method: Google Spreadsheet is measuring the pixel-width of a column in pixel (contrary to Excel which is using a different unit, see article Pixel, Point und Zentimeter in Excel), so that we can read the pixel-width from the software instead of measuring this via a pixel based tool like Photoshop. We are picking a few terms from the different languages, based on using Arial with size of 11 which comes visually next in text size to Arial 9pt in Excel. (No idea, why the textsize definitions differ in these two softwares, but the important thing – the ratio between the average character width – remains the same as everything is scaled up or down). After calculating the pixel width of the average characters we get the following values:

We can roughly conclude that the average Cyrillic letter needs 10% more width than the average of the Latin alphabet and that both Asian languages require 110% more width than Latin for their average character. This is quite a change in the game and requires that we move on to adjusted scatterplots with units being converted to pixels.

It will result in Russian term lengths being longer than we have been seen in number of characters. As for Japanese and Chinese, we now can estimate that some of Asian terms are even longer in pixel width than their English counterparts, particularly in the short English terms, and we will see proved in the scatterplots for Japanese and Chinese.

I have converted the scatterplots English – Language Y, which were based on the unit [number of characters] to the unit [pixel size], with their textsize being Arial 11 in Google spreadsheets. From comparing the different scatterplots we can conclude for needed screenspace for balance sheet accounting terms:

- The dominant factor is in general the length of the English term. The term length in any language correlates in a positive linear way with the English term length more or less. The correlation is smallest with German (r = 0.695) and the highest with Romanic languages (for example Spanish with r = 0.906).

- Thus, if you have the choice: start your screendesign with English terms.

Graph 8: Terms Lengths English and Language Y. Units in px based on Arial 9pt. Green Line = Added Pixel Constant to English Term Length.

Visual estimation of required additional pixel width

My idea is now to add on top of the English term length a particular pixel amount that will cover additional length when the English term is substituted by the translated term. The precise number of this constant varies according to the different languages and the absolute number dependent on the text size. However, the ratio of the constants remain basically the same as long as all the terms in the different languages share the same text size. Recommendations I have been heard like „add 30% of length“ do not reflect the full range of values and don’t accomplish the task particularly in the lower percentile of the values.

The summand is rendered as a green line running parallel to the diagonal. All data points underneath this line will fit into the reserved screen space when the summand is added to the length of the relating English term. In the underlying computation of the scatterplot we can easily apply different values for this constant. Just by looking at the amount of dots above the green constant line we know exactly how many terms would be truncated and we can decide if we accept that or want to apply an ever higher constant.

Let us have a look at the additional pixel widths required when our terms from the primary data set are substituting the English terms:

English > French / Italian / Spanish / Portuguiese / Dutch

For Romanic languages and Dutch, most of the translations will be wider than the English term, but in a proportional way. Using an additional 150 px on top of the pixel with of each English term will make sure that no term of these languages will be cut off.

English > German

If you need to be on the safe side and no truncation can be applied to German terms you should reserve space for all 64 characters respectively 406 px in Arial 9pt. Alternatively we could apply additional 150 px (which is a space of about 21 „n“s in Arial 9 pt) on the cost that a very small part of the terms (those above the green line) will be truncated.

English > Russian

Russian is correlating to English term lengths quite well, but not as good as Romanic languages. We need to add a larger screen space of 190 px to the English term and will have only very few translations been truncated.

English > Czech

To my surprise, the additional space of 150 px being added to the English term length covers almost all of the Czech terms. Merely 11 out of the 386 data points lay above the green line.

English > Japanese

Though Asian letters are much wider than Latin characters, the very large majority of japanese terms still require less space than their English counterparts. By adding 60 px (or 9 „n“s for fontsize independent) on top you make sure that nothing will be truncated. <Remark> The 5 Japanese terms above the green line contain Latin characters which make them less wider in width than calculated for the graph </Remark>

English > Chinese

Basically the same applies as in Japanese, but with fewer outliers.

Some concluding thoughts on the topic, which might include some take-aways

- If you have got all the translations at hand and use scatterplots, then you can precisely compute which space you need to avoid that terms are cut off.

- By applying the method shown above you can literally see how many (and even which!) terms will be truncated if you need to reserve less screen space.

- Correlation rules: The longer the English term, the longer will be the translated term – as a tendency but not in all cases.

- If you do the layout using English terms, your chances are high that the translated term will be longer but not exceedingly longer. At least translating into Romanic languages and Dutch, surely in Japanese and Chinese.

- Different Alphabets are an important factor for required screen space (based on using the same font and textsize).

- Term length can be measured in two different units: number of characters or pixels. Number of char’s keeps you independent from font and font size; using pixel units keeps you tightened to a particular font size. However, when calculating screen space for layouts you might need both units.

Of course, the findings of this article cannot be generalized beyond the domain of balance sheet accounting. However, it can create some indicators for the space required by different languages.

I have shown some methods to calculate very precisely spaces once most of the terms within the one domain are known. This knowledge should be preserved, analysed and documented so that we can it apply the next time a similar situation occurs. If we examine terms in different industries, maybe we can confirm some basic associations we have found above. Future work?

I wonder how companies which are localizing their software are dealing with this problem. Does anyone know more about this?

Literature

[ 1] Article „Histogram and Frequency Polygon“ in Harris, Robert L.: Information Graphics – A Comprehensive Illustrated Reference, New York 1999, p. 187ff.

[ 2 ] Article „Correlation Graph“ in Harris, 1999, p. 110 ff.

<Hint>This is THE REFERENCE for Charts and Diagrams. Needs to be on the shelf of every Information Designer.</Hint>

I want to recommend two other books on statistics:

Field, Andy et al.: Discovering Statistics using R, Los Angeles, 2nd edition 2013. A work of epic dimensions. <Warning> This book could be used to kill human beings in two ways: either by throwing the book with a weight of 2.340 kg at them. Or by letting them learn Statistics via R on 956 pages. I think the second death is worse. </Warning>

Hengst, Martin: Einführung in die mathematische Statistik und ihre Anwendung. Mannheim, 1967. <Personal remark> This is a book in the academic serie „BI Hochschultaschenbücher“. Very compact statistical knowledge on university level. I bought it back in 1971, but did not read it at that time. However, when I started discovering statistics four years ago, I was glad about its mathematical and roots-oriented approach. No Excel, no R, no computer, even no Desktop Publishing. At that time all diagrams had to be drawn by hand. It seems to be a bit out-fashioned by now but I like it just for this. There does not seem to be a updated edition. Rather 10 books from 1967 available at Amazon. </Personal Remark>

Abstract

NUIs als aktuelle Leitmedien verändern tradierte Designparadigmen. Als Folge ist in Arbeiten von jungen Webdesignern eine Abwendung vom starren funktionalistischen Design und eine Hinwendung zum Einsatz von Transitions und Animationen zu erkennen.

Aithalides analysiert die Highlights einer solchen Arbeit auf dem Hintergrund einer Printpublikation zu Nutzertypen in Deutschland. Die daraus in der interaktiven Applikation entstandene Dynamisierung von Information wird aus informationsdesignerischer Sicht untersucht und mit einem konventionellen, funktionalistisch geprägtem Designverständnis kontrastiert.

Kontext

Im Rahmen meiner LV Multimediales Informationsdesign 2014/15 erarbeiteten Studenten des Fachbereichs Online Medien zu verschiedenen Themen Webapplikationen, die sich durch gutes, interaktives und zeitgemäßes Informationsdesign auszeichnen: unter Anwendung reichhaltige Interaktion, schlüssige Narration und leicht verständliche Exploration. Was diese schlagwortartigen Begriffe bedeuten, wird in der Analyse der einzelnen Applikationen und der Diskussion der designerischen Hintergründe hoffentlich deutlich werden.

Den Applikationen lagen in Printform veröffentlichte Broschüren zugrunde; dabei sollten die Inhalte nicht nur in das Medium Web überführt werden und eine medienadäquate Benutzerführung geschaffen werden. Vielmehr galt es, die Inhalte mit den Möglichkeiten des neuen Mediums zu visualisieren und mittels Interaktionen erlebbar zu machen. Dies konnte auch dazu führen, dass die im Printbericht vorhandene Struktur verändert oder sogar komplett über Bord geworfen und eine neue Informationsarchitektur erarbeitet werden musste. Da die Arbeitsergebnisse nicht nur konzipiert, sondern in einem funktionierenden Prototypen umgesetzt werden sollten, mussten die Studenten innerhalb des gegebenen Zeitraums von 10 Wochen auch reichlich handwerkliches Knowhow zu CSS3 und verschiedenen JavaScript-Libraries erwerben, testen und anwenden.

Dieser erste Artikel in dieser Folge betrachtet die Applikation „Nutzertypen in Deutschland 2014“, der ein Kapitel der Studie „D21 Digital-Index 2014“ zum Inhalt hatte.

Eckdaten zur Applikation „Nutzertypen in Deutschland 2014“

- Die Applikation wurde für die folgenden Browser optimiert:

- Safari 8

- Chrome: leichte Darstellungsfehler

- Firefox und IE stellen die Applikation nicht korrekt dar.

- Die in diesem Artikel vorgestellte Applikation „Nutzertypen in Deutschland 2014“ kann jeder hier aufrufen.

- Zugrunde liegender Printbericht: D21 – Digital – Index 2014, Kapitel 2: Nutzertypen. Wer ist die digitale Gesellschaft?

Fachlicher Hintergrund der Applikation

Die Initiative D21 hatte 2014 eine empirische Studie veranlasst, die zum Ziel hat „… den Grad der Digitalisierung in der [deutschen] Bevölkerung in ihrer Vielschichtigkeit zwischen Leben und Arbeiten aus der Perspektive der Bürgerinnen und Bürger zu messen …..“ [2, S. 7]. Das finde ich an sich schon mal interessant, dass erkannt wurde, dass sich Digitalisierung nicht in der Auflistung von Hardware-KPIs wie Datendurchsatz, Breitband-Versorgung und Anzahl der verkauften Computer erschöpft, sondern dass es erforderlich ist, das Phänomen „Digitalisierung“ aus der Perspektive des Anwenders und seines Verhaltens und seiner Einstellungen zu denken und zu erfassen. Fragen zu stellen wie z.B.: Welche Geräte und Services werden in welchem Umfang genutzt? Zu welchem Zweck? Wenn sie nicht genutzt werden – weshalb werden sie nicht genutzt? Für mich ist das eine Untersuchung, die fundamentale Kennwerte (KPIs) zur User Experience mit den digitalen Medien identifiziert, systematisch erhebt und quantifiziert.

Für die Studie wurden über 200 Einzelinformationen identifiziert, die sich vier Themenbereichen (im Bericht „Dimensionen“ genannt) zuordnen lassen:

- Zugang – Nutzung der digitalen Infrastruktur

- Nutzungsvielfalt – Nutzungsintensität und Nutzungsvielfalt

- Kompetenz – Wissen über digitale Themen, technische und digitale Kompetenz

- Offenheit – Einstellung der Bevölkerung zu digitalen Themen und Neuerungen ( Ängste, Befürchtungen, Chancen, Vorteile)

Diese vier Themenbereiche stellen auch gleichzeitig die vier Komponenten des Digital-Index dar; jeder der vier Bereiche fließt als Sub-Index mit unterschiedlichem Anteil in die quantitative Gesamtgröße ein. Bestimmt wurde die Gewichtung des Anteils mittels Expertendiskurs [2, S. 8]. Die repräsentative Datenerhebung erfolgte mittels Befragung zur Ermittlung des aggregierten Gesamtgröße, des „D21 Digital-Index“ (n= 2995) [2, S.5]

Mittels statistischer Clusteranalysen wurde nach Gemeinsamkeiten und Unterschieden in der befragten Bevölkerung gesucht und als Ergebnis sechs verschiedene Nutzertypen identifiziert, die jeweils durch eine Adjektiv-Substantiv-Kombination benannt werden. Die errechneten Anteile der jeweiligen Typen an der deutschsprachigen Wohnbevölkerung ab 14 Jahren mit Festnetz-Telefonanschluss im Haushalt sind:

- Außenstehender Skeptiker: 26%

- Häuslicher Gelegenheitsnutzer: 30%

- Vorsichtiger Pragmatiker: 7%

- Reflektierter Profi: 18%

- Passionierte Onliner: 13%

- Smarter Mobilist: 6%

Soweit der zusammengefasste fachliche Hintergrund der erstellten Webapplikation, wie er im Printbericht dargelegt ist.

Informationsarchitektur, Benutzerführung und Navigation

Die Aufgabenstellung an die studentische Projektgruppe lautete, die Inhalte des Kapitels „Nutzertypen“ auf eine interaktive Applikation zu heben und erlebbar zu gestalten.

Ohne eine kurze Darstellung, was die Studie will, was der Digital-Index ist und wie er sich zusammen setzt, sind gewisse Detailinformationen im Kapitel nicht verständlich. Dies hat Konsequenzen für die Informationsarchitektur der Webapplikation: Die Projektgruppe setzte daher einen linearen Screenflow als Vorspann an den Anfang der Applikation, um mittels Text und Grafik diesen Kontext dem Nutzer vorab zu kommunizieren.

Abb. 1 — Informationsarchitektur der Applikation „Nutzertypen in Deutschland 2014“ nach dem D21-Digital-Index. Man beachte den Vorspann vor der eigentlichen Homepage.

„Vorab“ meint dabei: vor dem Übersichtsscreen über die sechs Nutzertypen. Dieser Übersichtsscreen wird als eigentliche Homepage verstanden und folgt darin auch dem Aufbau der gedruckten Broschüre, die auf einer Doppelseite einen Überblick über alle Nutzertypen gibt und deren wesentliche Eigenschaften qualitativ und quantitativ darlegt, bevor auf den folgenden Seiten der Steckbrief jedes einzelnen Typus auf einer Doppelseite erläutert wird.

In der interaktiven Webapplikation wird visuell jeder Nutzertyp durch eine Illustration der kennzeichnenden Eigenschaften sowie durch eine spezifische Farbe kodiert. Verglichen mit dem Printbericht wurde das Informationsdesign des Übersichtsscreens wesentlich verbessert: die Größe der farbigen Kreise korreliert mit dem Anteil des Typus an der Gesamtbevölkerung. Zusätzlich werden die Nutzungstypen entlang einer x-Achse entsprechend der Größe des Digi-Indexes angeordnet.

Abb. 2 — Die Homepage der Applikation: Übersicht der sechs Nutzertypen mit ihrem Digitalisierungsgrad und dem jeweiligen Anteil an der deutschen Bevölkerung.

Unterhalb – dieses örtliche Attribut ist im Sinne der IA als hierarchische Verortung gemeint – der zentralen Homepage kann der User frei navigieren. Durch Selektion eines Nutzertypen werden Seiten zugänglich, auf denen die Details zu den Subindikatoren dargelegt sind. Navigiert wird zwischen diesen Detailseiten durch Klick auf die horizontal angeordnete Subindikatoren-Leiste am unteren Screenrand. (siehe Abb. 3 Pageflow)

Zur Übersicht und zur Rücknavigation dient die hierarchische Navigation, die visuell als bogenförmige Gruppe von farbigen Kreisen am rechten Rand des Viewports dargestellt ist. Sehr gelungen ist bei dieser Navigation, dass alle Teile der Applikation (Vorspann, Übersicht Nutzertypen, Digi-Index jedes Nutzertypen) in jedem Screen sofort erreichbar sind.

Abb. 3 — Pageflow vom Übersichtsscreen zu den Detailinformationen der einzelnen Themengruppen innerhalb eines Nutzertyps. Hier Screenshots am Beispiel „Reflektierter Profi“.

Klassische Contentnavigation in neuem Look

Wegweisend für gutes interaktives Informationsdesign finde ich in der Applikation die doppelte Funktion vieler Informationselemente: zum einen sind sie Träger von Informationen, gleichzeitig sind sie aber auch Navigationselemente. Am Beispiel des Screens „Reflektierter Profi“: Das Feld Kompetenz in der unteren Dimensionsleiste zeigt die Punktzahl 68 dieses Subindexes für diesen Nutzertyp, gleichzeitig ist dies aber auch ein Sprungpunkt um zum Screen „Kompetenz“ mit den entsprechenden Details zu gelangen.

Die Absicht – oder in der UX-Sprache: die Teilaufgabe – des Nutzers ist hierbei ein Drilldown. Dieser Begriff kommt aus dem Online Analytic Processing (OLAP) und meint das Hineinzoomen in hierarchisch strukturierte Daten um eine Analyse zu verfeinern.

Die Methode, um den Nutzer dies durchzuführen zu lassen, ist die klassische Contentnavigation, so wie sie auf vielen Verzweigungsseiten im Web schon seit etlichen Jahre Anwendung findet. Insofern wurde in der vorliegenden Applikation die Methode der Teaser angewandt und ist nicht ungewöhnlich, sondern Best Practice. Was im vorliegenden Fall aber ungewöhnlich ist, ist die Formgebung dieser Teaser als Bubble. Das hat damit zu tun, dass die studentische Arbeitsgruppe die Kreisgestalt als visuelle Leitmotiv der Applikation wählten – wie sich unschwer anhand der Screenshots in Abb. 3 erkennen lässt. Darüber hinaus aber habe ich beim Navigieren gar nicht den Eindruck, unterschiedliche „Seiten aufzurufen“. Vielmehr fühlt sich so an, als ob die gewünschten Informationen auf meine Klicks auf ein und dieselbe Bühne gerufen werden und dabei einer Choreographie folgen. Das hat viel mit dem Konzept belebter Elemente zu tun. Doch dazu später mehr.

Momentan möchte ich darauf verweisen, dass hinter der Gestaltung dieser Contentnavigation die Absicht stand – und auch spürbar ist -, den User dazu zu bringen, den Informationsraum zu erforschen und sich dabei frei bewegen zu können. Der User soll explorativ den Informationsraum zu den verschiedenen Nutzertypen erkunden können: Drilldowns, Querbezüge, Rollups erforschen können und sich auf seine Weise die Informationen aneignen und verstehen können. Dies ist eine andere, ja geradezu gegensätzliche kommunikative Absicht als die des Vorspanns, bei dem es darauf ankam, in kurzer Zeit einige wenige, aber wichtige Informationen zu vermitteln.

Lässt man den User einen Informationsraum explorativ erkunden, so geht man als UX-Designer immer das Risiko ein, dass der Nutzer mit bestimmten Bereichen gar nicht in Berührung kommt; daher ist die Konzeption explorativen Vorgehens nicht in allen Nutzungssituationen oder Nutzungszielen sinnvoll. Auch die Verdichtung und Verlagerung von Informationen bedarf der Berücksichtigung von kognitiver Last des Nutzers und Steuerbarkeit der Applikation. Im der vorliegenden Applikation „Nutzertypen“ merkte ich an mir selber beim Durchklicken, wie sehr das Spielerische und die Freude am Entdecken in mir angesprochen wird. Der Reiz des Ausprobierens, ob und wie „es weiter geht“ führt zu einer Leichtigkeit im Umgang mit dieser Applikation, die den Nutzer in die Applikation und ihre Inhalte involviert und eine nachhaltige positive User Experience schafft.

Entzerrung von Information durch Verlagerung auf Interaktionsebenen

Damit Exploration als reizvolle Erkunden eines Themas und nicht nur als orientierungssuchendes Umherklicken in einer unverständlichen Umgebung empfunden wird, bedarf es der Anwendung verschiedener Methoden. Auf eine von ihnen möchte ich näher eingehen: die Entzerrung von Information durch Verlagerung auf Interaktionsebenen.

Betrachten wir das Diagramm in Abb. 4, das die Dimension „Offenheit“ des Nutzertyps „Reflektierter Profi“ zeigt wie es im Printbericht dargestellt ist. Dieses Diagramm wirkt durch die Linienverbindung der Werte ein wenig so, als sei es ein Polaritätsprofil / semantisches Differenzial dieses Nutzertyps. Problematisch ist dabei aus methodischer Sicht, dass in der Befragung keine Gegensatzpaare abgefragt wurden, sondern eine Lickert-Skala. Die der jeweiligen Aussage zustimmenden Probanden dieses Nutzertyps werden als Prozentsatz auf der x-Achse dargestellt, zusätzlich wird dieser Wert durch die Größe des Kreises visualisiert. Im Grunde genommen wäre hierfür ein Balkendiagramm die ausreichende Visualisierung.

Aus UX-Sicht weist dieses Diagramm ein Zuviel an textueller Information auf, das daher kommt, dass die abgefragte Aussagen vollständig auf der y-Achse wieder gegeben werden. Es gibt einen Hinweis darauf, dass die Autoren bzw. Layouter des Printberichtes das Problem der kognitiven Last erkannt haben: nämlich, dass sie versucht haben, durch Hervorhebung der Kernformulierung mittels fetten Schriftschnitts die Erfassbarkeit des Textinhaltes zu verbessern.

Abb. 4 — Diagramm im Printbericht: Zuviel textuelle Information verhindert schnelle Erfassbarkeit. [ 2, S. 25 ]

- Da ein Polaritätsprofil nur interessant ist, wenn zwei oder mehrere Objekte gleichzeitig dargestellt werden, entschied die Projektgruppe, die im Bericht dargestellten Informationen auf ihren Kern zu beschränken, indem keine Verbindungslinien zwischen den Werten gezogen werden, sondern diese lediglich durch Kreisgröße, numerischen Wert und Position auf einer y-Achse darzustellen.

- Als Maßnahme zur Informationsentzerrung wird auf die Darstellung der vollständigen Aussagen entlang einer Achse vollständig verzichtet. Stattdessen erhalten die Bubbles selbst ein Stichwort neben dem prominenten numerischen Wert. Die Darstellung der vollständigen Aussage wird also auf eine andere Modusebene verlagert, die durch Hovern des jeweiligen Kreises eingeblendet wird. Dieses ist vergleichbar dem Kniff, bei Charts ergänzende textuelle oder numerische Information in Tooltip-ähnliche GUI-Elemente zu verlagern, die nur dann sichtbar werden, wenn einzelne Datenpunkte gehovert werden.

Sehr elegant gestaltet ist die Transition zwischen den beiden Modi Hover/Normal: Wie bei einer realen Scheibe scheint sich die Bubble zu drehen, als ob sie an einem unsichtbaren Faden aufgehangen wäre, und zeigt ihre andere Seite.

Informationsdesign als mechanisches Ballett

Überhaupt: die Transitions! Die Art und Weise, wie Informationen in den Screen kommen, wie Screenelemente auf Hovern reagieren, das lebendige Pulsieren der Tag-Cloud, das Zusammenführen von Textenteilen, die sich während meines Scrollens sich zu kompletten Aussagen reißverschlussartig ergänzen, all das im richtig dimensionierten räumlichen und zeitlichen Maß – das ist schon gut inszeniertes mechanisches Ballett. Zwar nicht eines, das choreografiert ist für menschliche Körper. Aber eines, das choreografiert ist für Informationen, die sich schon irgendwie wesenhaft verhalten.

Die Art und Weise, wie sie von unten herbei huschen, über die Endposition hinaus schießen, leicht federn und dann ihre Position in der vertikalen Mitte des Screens einnehmen, um dann brav und rasend schnell auf die darzustellenden Ziffern hochzuzählen, hat etwas Magisches. Als Benutzer fühle mich dabei ein wenig wie ein Zauberer, der Informationen dazu veranlasst auf einer Bühne aufzutreten, mir ihre Geschichte zu erzählen und wieder abzutreten. Hier ein Recording von Interaktionen und Systemreaktion, das einen ersten Eindruck der Transitions vermittelt:

Webbasierte Animationen und Transitions sind vom Handwerklich-Technischen her betrachtet nichts aktuell Neues. Ihnen liegen JavaScript- und/oder CSS3-Libraries zugrunde. Trotzdem braucht es gute handwerklich Leistung und ein gutes Gefühl für die richtige Dimensionierung der Parameter des passend platzierten Effektes, so wie es in der vorliegenden Applikation im Großen und Ganzen auch zu finden ist.

Noch bemerkenswerter als die handwerkliche Leistung finde ich die Durchgängigkeit, mit der graphische Elemente und Texte in der Applikation animiert wurden. Dies deswegen, weil hier ein bisher gültiges Paradigma des Informationsdesigns gekippt wird, das lautete: Animation und Information schliessen sich in der Regel aus! So statuiert der Wikipedia-Eintrag Animation im Abschnitt Animation in der Lernpsychologie: „Animierte Bilder haben gegenüber statischen Repräsentationen den Vorteil, Veränderung explizit abbilden zu können. Sie stellen jedoch auch hohe Verarbeitungsanforderungen an die Lernenden. Daher sollten sie mit Bedacht eingesetzt und auf Sachverhalte beschränkt werden, die tatsächlich von einer bewegten Darstellung profitieren. Häufig werden jedoch selbst solche Medienbestandteile animiert und damit effekthascherisch überbetont, die dafür weitestgehend ungeeignet sind, wie zum Beispiel Texte.“ [3]

Ich denke, es ist an der Zeit, ein wenig hinter dieses Paradigma zu schauen und zu überlegen, ob dieses heute noch gültig ist. Es könnte sein, dass es sich bei der Behauptung der mangelnden Eignung animierter Information um einen Mythos handelt, der vor vielen Jahren in einem bestimmten Kontext nachgewiesen und publiziert wurde, seitdem weitergereicht wird und immer wieder erneut zitiert. Aber niemals empirisch unter aktuellen Bedingungen überprüft!

Animation = (funktionsloses) Ornament?

Animation – wenn ich dies höre, klingelt bei mir als Designer sofort die Alarmglocke. Bei diesem Wort befürchte ich das Gleiche wie der Autor des obigen Wikipedia-Zitates: Effekthascherei, Aufmerksamkeit ohne fundierte Inhalte, Ablenkung vom Wesentlichen, zu laut, zu bunt, zu viel! Dies geht gegen das Fokussierte, das Reduzierte, die klare Botschaft, das „Weniger ist mehr“, das so mühsam durch die Auseinandersetzung mit der visuellen Formwerdung der Inhalte erarbeitet werden muss. Welcher Designer kennt es nicht, wie oft eine visuelle Kommunikation im Entstehensprozess gesehen, assoziiert, umgestellt, gestrafft, reduziert werden muss, wie viele Ideen gestrichen werden müssen bis man an den klaren Kern kommt. Und dann kommt jemand mit überquellenden Powerpoint-Folien, bei denen Texte und Clipart-Grafiken auf die Folie wirbeln, zoomen und schachbrettern, was die Effektmaschine hergeben – es braucht ja nur einen Klick in die Animationsleiste. Formen, die keine Aussage treffen, sondern im schlimmsten Fall von der Inhaltslosigkeit der Aussagen ablenken sollen – das ist meine Furcht als Designer.

Als solcher weiss ich die Paradigmen des Funktionalismus zu schätzen. Einer dieser Leitsätze ist „Form follows function“ (Louis Sullivan). Die Gestaltung von Dingen soll sich aus der Funktion der Dinge ableiten. Andersherum gesagt: es soll nichts geben, was nicht eine Funktion unterstützt.

„Ornament ist vergeudete arbeitskraft und dadurch vergeudete gesundheit. So war es immer. Heute bedeutet es aber auch vergeudetes material, und beides bedeutet vergeudetes kapital.“ beschrieb Adolf Loos 1908 in seiner Schrift Ornament und Verbrechen, deren Titel designgeschichtlich einen weiteren Leitsatz des Funktionalismus zugespitzte. Sein Gedankengang: der Aufwand, der das Ornament erschafft, sei vergeudeter Aufwand, der besser dem Funktionalem dienen könne. Auf unser Thema übertragen führt dies zur Frage: ist die Animation ein zur Information hinzugefügtes Ornament, das eigentlich völlig überflüssig ist und nach dem Loos’schen Verständnis ebenfalls ein Verbrechen wäre?

Nun, der Begriff „Animation“ leitet sich aus dem Lateinischen „anima“ für Seele ab. Das Animierte ist das Beseelte, etwas das mit einer gewissen Autonomie agiert und reagiert. Aus diesem Blickwinkel könnte man sogar das System, mit dem der User interagiert, das die gewünschten Informationen bereitstellt und wieder wegnimmt und das auf Fehleingaben informierend antwortet, als beseeltes Wesen, als animiert betrachten. Man könnte nun den Standpunkt vertreten , es sei eigentlich nur konsequent, wenn die Informationen – genauer: Darstellungen (Text, Zahlen, Formen), die Informationen tragen – auch eine Art Eigenleben führen. Es wäre aber andererseits auch argumentierbar, dass es solche Ornamente gar erst nicht bedarf, da das Beseelte sich bereits im Verhalten des Systems ausdrücke.

Animierte Objekte in NUIs

Dass von Studenten Animationen im Informationsdesign ohne Scheu angewandt werden, mag einen ganz einfachen (Hinter-)Grund haben: sie sind in den vergangenen 10 Jahren groß geworden mit Geräten wie SmartPhone und Tablets. Diese Touch-Geräte sind in in einer neueren Phase der Hardware-Technologie entstanden und ihre Interfaces sind anders konzipiert als die der WIMP (Windows Mouse Pointer)-Systeme. Screeninhalte werden beispielsweise nicht gescrollt, sondern mittels Flick-Geste angeschubst; die Reaktion des Screeninhaltes auf die Geste entspricht demjenigen physischer Gegenstände: schnelle Bewegung am Anfang, danach allmähliches Verlangsamen. Diese sich über einen Zeitraum verändernde visuelle Reaktion des Screeninhaltes ist ebenfalls eine Animation – aus technischer Sicht wie aus Nutzersicht. Und sie hat eine Funktion, nämlich das steuerbare „Scrollen“ des Screeninhaltes.

Ein anderes Beispiel für eine funktionale Animation ist der Federeffekt im iOS 7: Gelangt der User beim Scrollen eines Inhaltes mittels Swipe oder Flick-Geste an dessen Anfang oder Ende, so wird diese Begrenzung deutlich, indem der Inhalt zwar über diese Begrenzung hinaus läuft, aber sofort wieder an die Begrenzung zurückfedert. Der Screeninhalt vollzieht eine nicht-lineare Bewegung, die autonom abläuft und so aussieht, als sei dieser Inhalt ein physikalisches Objekt, das mittels einer unsichtbaren Feder mit dem Rand des Screens verbunden – also eine Animation. Das System gibt also keinen textuellen Warnhinweis (z.B. „Sie können nicht weiterscrollen“) oder graphische Warnung (z.B. rotes Warndreieck-Icon am Ende der Scrollbar) an den Nutzer aus. Vielmehr versteht der Nutzer die Aussage einzig des Systems anhand des Verhaltens der Elemente, eben der Art und Weise, wie diese animiert sind. Deswegen werden diese Interfaces eben auch „natural“ genannt, da sie sich anfühlen wie das, was wir aus unserer physischen, natürlichen Umgebung kennen.

Die NUIs sind bereits seit einiger Zeit Leitmedium geworden; sie produzieren neue Standards bezüglich Look und Feel von Benutzungsoberflächen. Und damit kommt auch die Nutzererwartung, dass sich auch die Objekte in Webmedien mehr wie natürliche Objekte verhalten sollen. Und unter diesem Blickwinkel stellt sich mir die Frage: Was wirkt natürlicher – Texte, die auf einer Screenfläche bereits vorhanden sind wie bei einem bedrucktem Blatt Papier? Oder Texte, die beim Scrollen von ausserhalb zusammenkommen und sich auf der Fläche positionieren? Ehrlich gesagt: auf mich wirkt zweites natürlicher – und spannungsvoller erst recht.

Ich denke: im Zeitalter von NUIs ist es wichtig, den Gestaltungselementen Lebendigkeit und Beseeltheit mitzugeben. Und dies selbstverständlich nicht als inhaltsleere Effekthascherei, sondern zur Optimierung von Steuerbarkeit von Controls und inhaltlicher Aussage des inhaltlich Kommunizierten.

Kinetic Type

Die klassische Form, ja sozusagen die reinste Form, von Information ist der Text. Der Text gilt als Verkörperung des Satzes, der wiederum versprachlichter Gedanke ist. Es gibt sogar Menschen, die für sich ausschließlich nur geschriebenen Text oder gesprochenes Wort als Information zulassen und ausschließlich Zeitungen mit möglichst geringem Bildanteil lesen. TV oder das Genre der Illustrierten werden in der Wertewelt dieser Menschen nicht als Informationsmedium akzeptiert.

Nun, solche Sichtweisen würde der Mediengestalter von heute eher als Haltung einer Randgruppe von Sonderlingen einordnen. Nichtsdestotrotz ist das Konzept der starren Typografie auch heute noch ein wirkendes Paradigma in der Mediengestaltung, das optimale Effizienz und Effektivität beim Aufnehmen und Verstehen der durch Texte vermittelten Informationen verspricht. In unserer Vorstellung hat ein Text gefälligst starr zu sein und an derselben Stelle zu stehen, damit wir ihn optimal erfassen können. Der menschliche Wahrnehmungsvorgang mit seinen Fixationen und Sakkaden [5] legt die Ansicht ja nahe: das Lesen von Text ist ein eigentlich mühsamer und mit Fehlern behafteter Vorgang, der keine weitere Komplikation durch tanzende Buchstaben, vibrierende Wörter und die Position verändernde Zeilen gebrauchen kann.